注意

跳转至末尾 下载完整的示例代码。

基于 PyTorch 的 USB 半监督学习#

创建日期: 2023 年 12 月 07 日 | 最后更新: 2024 年 03 月 07 日 | 最后验证: 未验证

作者: Hao Chen

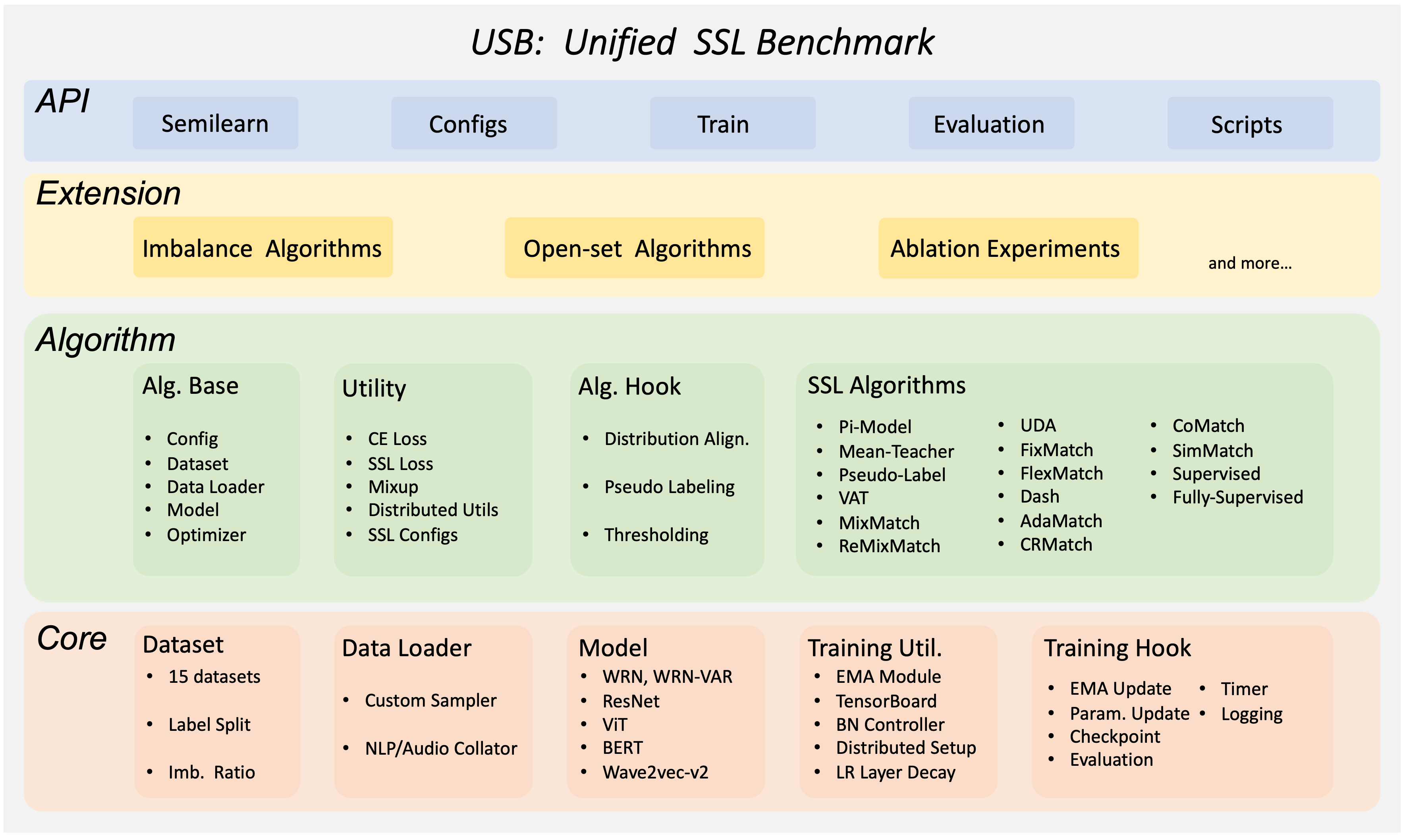

Unified Semi-supervised learning Benchmark (USB) 是一个基于 PyTorch 构建的半监督学习 (SSL) 框架。基于 PyTorch 提供的 Datasets 和 Modules,USB 成为了一个灵活、模块化且易于使用的半监督学习框架。它支持各种半监督学习算法,包括 FixMatch、FreeMatch、DeFixMatch、SoftMatch 等。它还支持各种不平衡半监督学习算法。USB 中包含了计算机视觉、自然语言处理和语音处理不同数据集的基准测试结果。

本教程将引导您了解 USB 闪电包的基础知识。让我们开始使用预训练的 Vision Transformers (ViT) 在 CIFAR-10 上训练 FreeMatch/SoftMatch 模型!我们将展示如何轻松更改半监督算法并在不平衡数据集上进行训练。

半监督学习中 FreeMatch 和 SoftMatch 简介#

这里我们简要介绍 FreeMatch 和 SoftMatch。首先,我们介绍一种著名的半监督学习基线 FixMatch。FixMatch 是一个非常简单的半监督学习框架,它利用强增强来为无标签数据生成伪标签。它采用置信度阈值策略,以固定的阈值过滤掉低置信度的伪标签。FreeMatch 和 SoftMatch 是改进 FixMatch 的两种算法。FreeMatch 提出了一种自适应阈值策略来替代 FixMatch 中的固定阈值策略。自适应阈值策略根据模型在每个类上的学习状态逐渐提高阈值。SoftMatch 将置信度阈值策略的思想吸收为一种加权机制。它提出了一种高斯加权机制来克服伪标签的数量-质量权衡问题。在本教程中,我们将使用 USB 来训练 FreeMatch 和 SoftMatch。

使用 USB 在 CIFAR-10 上仅用 40 个标签训练 FreeMatch/SoftMatch#

USB 易于使用和扩展,对于小型团队来说经济实惠,并且对于开发和评估 SSL 算法非常全面。USB 提供了基于一致性正则化的 14 种 SSL 算法的实现,以及来自 CV、NLP 和 Audio 领域的 15 个评估任务。它采用模块化设计,允许用户通过添加新算法和任务来轻松扩展该包。它还支持 Python API,以便更容易地将不同的 SSL 算法适配到新数据上。

现在,让我们使用 USB 在 CIFAR-10 上训练 FreeMatch 和 SoftMatch。首先,我们需要安装 USB 包 semilearn 并从 USB 导入必要的 API 函数。如果您在 Google Colab 中运行此程序,请运行以下命令来安装 semilearn: !pip install semilearn。

以下是我们将在 semilearn 中使用的函数列表

get_dataset用于加载数据集,这里我们使用 CIFAR-10get_data_loader用于创建训练(有标签和无标签)和测试数据

loaders,无标签训练的 loader 将提供无标签数据的强增强和弱增强 - get_net_builder 用于创建模型,这里我们使用预训练的 ViT - get_algorithm 用于创建半监督学习算法,这里我们使用 FreeMatch 和 SoftMatch - get_config:用于获取算法的默认配置 - Trainer:一个用于在数据集上训练和评估算法的 Trainer 类

请注意,使用 semilearn 包进行训练需要 CUDA 启用的后端。有关在 Google Colab 中启用 CUDA 的说明,请参阅 在 Google Colab 中启用 CUDA。

import semilearn

from semilearn import get_dataset, get_data_loader, get_net_builder, get_algorithm, get_config, Trainer

导入必要的函数后,我们首先设置算法的超参数。

config = {

'algorithm': 'freematch',

'net': 'vit_tiny_patch2_32',

'use_pretrain': True,

'pretrain_path': 'https://github.com/microsoft/Semi-supervised-learning/releases/download/v.0.0.0/vit_tiny_patch2_32_mlp_im_1k_32.pth',

# optimization configs

'epoch': 1,

'num_train_iter': 500,

'num_eval_iter': 500,

'num_log_iter': 50,

'optim': 'AdamW',

'lr': 5e-4,

'layer_decay': 0.5,

'batch_size': 16,

'eval_batch_size': 16,

# dataset configs

'dataset': 'cifar10',

'num_labels': 40,

'num_classes': 10,

'img_size': 32,

'crop_ratio': 0.875,

'data_dir': './data',

'ulb_samples_per_class': None,

# algorithm specific configs

'hard_label': True,

'T': 0.5,

'ema_p': 0.999,

'ent_loss_ratio': 0.001,

'uratio': 2,

'ulb_loss_ratio': 1.0,

# device configs

'gpu': 0,

'world_size': 1,

'distributed': False,

"num_workers": 4,

}

config = get_config(config)

然后,我们加载数据集并为训练和测试创建数据加载器。并指定要使用的模型和算法。

dataset_dict = get_dataset(config, config.algorithm, config.dataset, config.num_labels, config.num_classes, data_dir=config.data_dir, include_lb_to_ulb=config.include_lb_to_ulb)

train_lb_loader = get_data_loader(config, dataset_dict['train_lb'], config.batch_size)

train_ulb_loader = get_data_loader(config, dataset_dict['train_ulb'], int(config.batch_size * config.uratio))

eval_loader = get_data_loader(config, dataset_dict['eval'], config.eval_batch_size)

algorithm = get_algorithm(config, get_net_builder(config.net, from_name=False), tb_log=None, logger=None)

现在我们可以开始在带有 40 个标签的 CIFAR-10 上训练算法了。我们训练 500 个迭代,并每 500 个迭代进行一次评估。

trainer = Trainer(config, algorithm)

trainer.fit(train_lb_loader, train_ulb_loader, eval_loader)

最后,让我们在验证集上评估训练好的模型。在仅使用 40 个 CIFAR-10 标签上用 FreeMatch 训练 500 个迭代后,我们得到了一个分类器,在验证集上达到了约 87% 的准确率。

trainer.evaluate(eval_loader)

使用 USB 在不平衡的 CIFAR-10 上使用特定的不平衡算法训练 SoftMatch#

现在,假设我们有不平衡的 CIFAR-10 有标签集和无标签集,并且我们想在上面训练一个 SoftMatch 模型。我们通过将 lb_imb_ratio 和 ulb_imb_ratio 设置为 10 来创建一个不平衡的有标签集和不平衡的无标签集。此外,我们将 algorithm 替换为 softmatch,并将 imbalanced 设置为 True。

config = {

'algorithm': 'softmatch',

'net': 'vit_tiny_patch2_32',

'use_pretrain': True,

'pretrain_path': 'https://github.com/microsoft/Semi-supervised-learning/releases/download/v.0.0.0/vit_tiny_patch2_32_mlp_im_1k_32.pth',

# optimization configs

'epoch': 1,

'num_train_iter': 500,

'num_eval_iter': 500,

'num_log_iter': 50,

'optim': 'AdamW',

'lr': 5e-4,

'layer_decay': 0.5,

'batch_size': 16,

'eval_batch_size': 16,

# dataset configs

'dataset': 'cifar10',

'num_labels': 1500,

'num_classes': 10,

'img_size': 32,

'crop_ratio': 0.875,

'data_dir': './data',

'ulb_samples_per_class': None,

'lb_imb_ratio': 10,

'ulb_imb_ratio': 10,

'ulb_num_labels': 3000,

# algorithm specific configs

'hard_label': True,

'T': 0.5,

'ema_p': 0.999,

'ent_loss_ratio': 0.001,

'uratio': 2,

'ulb_loss_ratio': 1.0,

# device configs

'gpu': 0,

'world_size': 1,

'distributed': False,

"num_workers": 4,

}

config = get_config(config)

然后,我们重新加载数据集并为训练和测试创建数据加载器。并指定要使用的模型和算法。

dataset_dict = get_dataset(config, config.algorithm, config.dataset, config.num_labels, config.num_classes, data_dir=config.data_dir, include_lb_to_ulb=config.include_lb_to_ulb)

train_lb_loader = get_data_loader(config, dataset_dict['train_lb'], config.batch_size)

train_ulb_loader = get_data_loader(config, dataset_dict['train_ulb'], int(config.batch_size * config.uratio))

eval_loader = get_data_loader(config, dataset_dict['eval'], config.eval_batch_size)

algorithm = get_algorithm(config, get_net_builder(config.net, from_name=False), tb_log=None, logger=None)

现在我们可以开始在带有 40 个标签的 CIFAR-10 上训练算法了。我们训练 500 个迭代,并每 500 个迭代进行一次评估。

trainer = Trainer(config, algorithm)

trainer.fit(train_lb_loader, train_ulb_loader, eval_loader)

最后,让我们在验证集上评估训练好的模型。

trainer.evaluate(eval_loader)

参考文献: - [1] USB: microsoft/Semi-supervised-learning - [2] Kihyuk Sohn 等人. FixMatch: Simplifying Semi-Supervised Learning with Consistency and Confidence - [3] Yidong Wang 等人. FreeMatch: Self-adaptive Thresholding for Semi-supervised Learning - [4] Hao Chen 等人. SoftMatch: Addressing the Quantity-Quality Trade-off in Semi-supervised Learning