注意

转到底部 下载完整的示例代码。

从零开始的NLP:使用字符级RNN进行姓名分类#

创建时间:2017年3月24日 | 最后更新:2025年3月14日 | 最后验证:2024年11月05日

作者: Sean Robertson

本教程是三部曲系列的一部分

我们将构建和训练一个基本的字符级循环神经网络(RNN)来对单词进行分类。本教程以及另外两个自然语言处理(NLP)“从零开始”的教程 从零开始的NLP:使用字符级RNN生成姓名 和 从零开始的NLP:使用序列到序列网络和注意力机制进行翻译,展示了如何预处理数据以模拟NLP。特别是,这些教程从底层展示了NLP数据的预处理是如何工作的。

字符级RNN将单词读取为一个字符序列——在每一步输出一个预测和一个“隐藏状态”,将其前一个隐藏状态馈送到每一步。我们将最终预测作为输出,即该单词所属的类别。

具体来说,我们将基于18种不同语言的数千个姓氏进行训练,并根据拼写预测一个姓名属于哪种语言。

推荐准备#

在开始本教程之前,建议您已安装PyTorch,并对Python编程语言和张量(Tensors)有基本了解。

https://pytorch.ac.cn/ 获取安装说明

PyTorch深度学习:60分钟速成班 以便全面了解PyTorch并学习张量的基础知识。

通过实例学习PyTorch,进行广泛而深入的概览

为前Torch用户准备的PyTorch教程,如果您是前Lua Torch用户

了解RNN及其工作原理也会有所帮助。

循环神经网络的不可思议的有效性 展示了大量现实生活中的例子。

理解LSTM网络 主要讲解LSTM,但也涵盖了RNN的一般信息。

准备Torch#

设置torch以默认使用正确的设备,根据您的硬件(CPU或CUDA)进行GPU加速。

import torch

# Check if CUDA is available

device = torch.device('cpu')

if torch.cuda.is_available():

device = torch.device('cuda')

torch.set_default_device(device)

print(f"Using device = {torch.get_default_device()}")

Using device = cuda:0

准备数据#

从此处下载数据并解压到当前目录。

在data/names目录中包含18个文本文件,文件名格式为[Language].txt。每个文件包含大量姓名,每行一个姓名,大部分是罗马化(但我们仍需要从Unicode转换为ASCII)。

第一步是定义和清理我们的数据。首先,我们需要将Unicode转换为纯ASCII,以限制RNN的输入层。这通过将Unicode字符串转换为ASCII并仅允许一小组允许的字符来实现。

import string

import unicodedata

# We can use "_" to represent an out-of-vocabulary character, that is, any character we are not handling in our model

allowed_characters = string.ascii_letters + " .,;'" + "_"

n_letters = len(allowed_characters)

# Turn a Unicode string to plain ASCII, thanks to https://stackoverflow.com/a/518232/2809427

def unicodeToAscii(s):

return ''.join(

c for c in unicodedata.normalize('NFD', s)

if unicodedata.category(c) != 'Mn'

and c in allowed_characters

)

以下是将Unicode字母姓名转换为纯ASCII的示例。这简化了输入层。

print (f"converting 'Ślusàrski' to {unicodeToAscii('Ślusàrski')}")

converting 'Ślusàrski' to Slusarski

将姓名转换为张量#

既然我们已经组织好了所有姓名,我们就需要将它们转换为张量才能使用。

为了表示一个字母,我们使用一个大小为<1 x n_letters>的“独热编码向量”(one-hot vector)。独热编码向量除了在当前字母索引处为1之外,其余位置都为0,例如"b" = <0 1 0 0 0 ...>。

为了构成一个单词,我们将一堆这样的向量连接成一个二维矩阵<line_length x 1 x n_letters>。

多出的一个维度是因为PyTorch假定所有东西都在批次中——我们这里只使用了批次大小为1。

# Find letter index from all_letters, e.g. "a" = 0

def letterToIndex(letter):

# return our out-of-vocabulary character if we encounter a letter unknown to our model

if letter not in allowed_characters:

return allowed_characters.find("_")

else:

return allowed_characters.find(letter)

# Turn a line into a <line_length x 1 x n_letters>,

# or an array of one-hot letter vectors

def lineToTensor(line):

tensor = torch.zeros(len(line), 1, n_letters)

for li, letter in enumerate(line):

tensor[li][0][letterToIndex(letter)] = 1

return tensor

以下是如何为单个字符或多个字符字符串使用lineToTensor()的示例。

print (f"The letter 'a' becomes {lineToTensor('a')}") #notice that the first position in the tensor = 1

print (f"The name 'Ahn' becomes {lineToTensor('Ahn')}") #notice 'A' sets the 27th index to 1

The letter 'a' becomes tensor([[[1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0.]]], device='cuda:0')

The name 'Ahn' becomes tensor([[[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0.]],

[[0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0.]],

[[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0.]]], device='cuda:0')

恭喜您,您已经为这项学习任务构建了基础的张量对象!您可以在其他涉及文本的RNN任务中使用类似的方法。

接下来,我们需要将所有示例组合成一个数据集,以便我们可以训练、测试和验证我们的模型。为此,我们将使用Dataset和DataLoader类来存储我们的数据集。每个Dataset需要实现三个函数:__init__、__len__和__getitem__。

from io import open

import glob

import os

import time

import torch

from torch.utils.data import Dataset

class NamesDataset(Dataset):

def __init__(self, data_dir):

self.data_dir = data_dir #for provenance of the dataset

self.load_time = time.localtime #for provenance of the dataset

labels_set = set() #set of all classes

self.data = []

self.data_tensors = []

self.labels = []

self.labels_tensors = []

#read all the ``.txt`` files in the specified directory

text_files = glob.glob(os.path.join(data_dir, '*.txt'))

for filename in text_files:

label = os.path.splitext(os.path.basename(filename))[0]

labels_set.add(label)

lines = open(filename, encoding='utf-8').read().strip().split('\n')

for name in lines:

self.data.append(name)

self.data_tensors.append(lineToTensor(name))

self.labels.append(label)

#Cache the tensor representation of the labels

self.labels_uniq = list(labels_set)

for idx in range(len(self.labels)):

temp_tensor = torch.tensor([self.labels_uniq.index(self.labels[idx])], dtype=torch.long)

self.labels_tensors.append(temp_tensor)

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

data_item = self.data[idx]

data_label = self.labels[idx]

data_tensor = self.data_tensors[idx]

label_tensor = self.labels_tensors[idx]

return label_tensor, data_tensor, data_label, data_item

在这里,我们可以将示例数据加载到NamesDataset中。

alldata = NamesDataset("data/names")

print(f"loaded {len(alldata)} items of data")

print(f"example = {alldata[0]}")

loaded 20074 items of data

example = (tensor([12], device='cuda:0'), tensor([[[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0.]],

[[0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0.]],

[[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0.]],

[[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0.]],

[[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0.]],

[[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0.]]], device='cuda:0'), 'Arabic', 'Khoury')

- 使用数据集对象可以让我们轻松地将数据分割成训练集和测试集。这里我们创建了一个80/20

分割,但

torch.utils.data提供了更多有用的工具。这里我们指定了一个生成器,因为我们需要使用

与PyTorch默认设置相同的设备。

train_set, test_set = torch.utils.data.random_split(alldata, [.85, .15], generator=torch.Generator(device=device).manual_seed(2024))

print(f"train examples = {len(train_set)}, validation examples = {len(test_set)}")

train examples = 17063, validation examples = 3011

现在我们拥有了一个基本数据集,其中包含**20074**个示例,每个示例都是一个标签和姓名的配对。我们还将数据集分割成了训练集和测试集,以便我们可以验证我们构建的模型。

创建网络#

在自动微分(autograd)出现之前,在Torch中创建一个循环神经网络需要在多个时间步上克隆一个层的参数。这些层持有现在完全由图本身处理的隐藏状态和梯度。这意味着您可以非常“纯粹”地实现一个RNN,就像普通的馈通网络一样。

这个CharRNN类实现了一个具有三个组件的RNN。首先,我们使用nn.RNN实现。接下来,我们定义一个将RNN隐藏层映射到我们输出的层。最后,我们应用一个softmax函数。与将每个层实现为nn.Linear相比,使用nn.RNN可以显著提高性能,例如cuDNN加速的内核。它也简化了forward()中的实现。

import torch.nn as nn

import torch.nn.functional as F

class CharRNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(CharRNN, self).__init__()

self.rnn = nn.RNN(input_size, hidden_size)

self.h2o = nn.Linear(hidden_size, output_size)

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, line_tensor):

rnn_out, hidden = self.rnn(line_tensor)

output = self.h2o(hidden[0])

output = self.softmax(output)

return output

然后,我们可以创建一个具有58个输入节点、128个隐藏节点和18个输出的RNN。

n_hidden = 128

rnn = CharRNN(n_letters, n_hidden, len(alldata.labels_uniq))

print(rnn)

CharRNN(

(rnn): RNN(58, 128)

(h2o): Linear(in_features=128, out_features=18, bias=True)

(softmax): LogSoftmax(dim=1)

)

之后,我们可以将张量传递给RNN以获得预测输出。随后,我们使用一个名为label_from_output的辅助函数来从类别中提取文本标签。

def label_from_output(output, output_labels):

top_n, top_i = output.topk(1)

label_i = top_i[0].item()

return output_labels[label_i], label_i

input = lineToTensor('Albert')

output = rnn(input) #this is equivalent to ``output = rnn.forward(input)``

print(output)

print(label_from_output(output, alldata.labels_uniq))

tensor([[-2.8962, -2.8510, -2.8362, -3.0261, -2.9197, -2.8341, -2.8506, -2.9229,

-2.9940, -2.9538, -2.8334, -2.8647, -2.9086, -2.8056, -2.8497, -2.8957,

-2.8448, -2.9723]], device='cuda:0', grad_fn=<LogSoftmaxBackward0>)

('Spanish', 13)

训练#

训练网络#

现在训练这个网络只需要给它看大量示例,让它进行猜测,并告诉它是否错了。

我们通过定义一个train()函数来实现这一点,该函数使用小批量(minibatches)在给定数据集上训练模型。RNN与其他网络类似地进行训练;因此,为完整起见,我们在此包含一个批量训练方法。该循环(for i in batch)在调整权重之前计算批次中每个项目的损失。此操作会重复进行,直到达到指定的训练轮数(epochs)。

import random

import numpy as np

def train(rnn, training_data, n_epoch = 10, n_batch_size = 64, report_every = 50, learning_rate = 0.2, criterion = nn.NLLLoss()):

"""

Learn on a batch of training_data for a specified number of iterations and reporting thresholds

"""

# Keep track of losses for plotting

current_loss = 0

all_losses = []

rnn.train()

optimizer = torch.optim.SGD(rnn.parameters(), lr=learning_rate)

start = time.time()

print(f"training on data set with n = {len(training_data)}")

for iter in range(1, n_epoch + 1):

rnn.zero_grad() # clear the gradients

# create some minibatches

# we cannot use dataloaders because each of our names is a different length

batches = list(range(len(training_data)))

random.shuffle(batches)

batches = np.array_split(batches, len(batches) //n_batch_size )

for idx, batch in enumerate(batches):

batch_loss = 0

for i in batch: #for each example in this batch

(label_tensor, text_tensor, label, text) = training_data[i]

output = rnn.forward(text_tensor)

loss = criterion(output, label_tensor)

batch_loss += loss

# optimize parameters

batch_loss.backward()

nn.utils.clip_grad_norm_(rnn.parameters(), 3)

optimizer.step()

optimizer.zero_grad()

current_loss += batch_loss.item() / len(batch)

all_losses.append(current_loss / len(batches) )

if iter % report_every == 0:

print(f"{iter} ({iter / n_epoch:.0%}): \t average batch loss = {all_losses[-1]}")

current_loss = 0

return all_losses

我们现在可以为数据集使用小批量训练,训练指定的轮数。为了加快构建速度,本示例中的训练轮数已减少。您可以使用不同的参数获得更好的结果。

start = time.time()

all_losses = train(rnn, train_set, n_epoch=27, learning_rate=0.15, report_every=5)

end = time.time()

print(f"training took {end-start}s")

training on data set with n = 17063

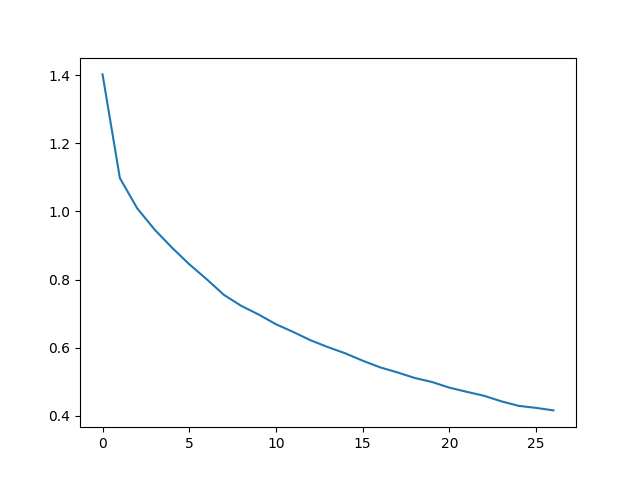

5 (19%): average batch loss = 0.877891722006078

10 (37%): average batch loss = 0.6838399407782949

15 (56%): average batch loss = 0.5772297213089955

20 (74%): average batch loss = 0.48974639862051866

25 (93%): average batch loss = 0.4353903183734024

training took 345.4310917854309s

绘制结果#

绘制all_losses中的历史损失图,显示网络正在学习。

import matplotlib.pyplot as plt

import matplotlib.ticker as ticker

plt.figure()

plt.plot(all_losses)

plt.show()

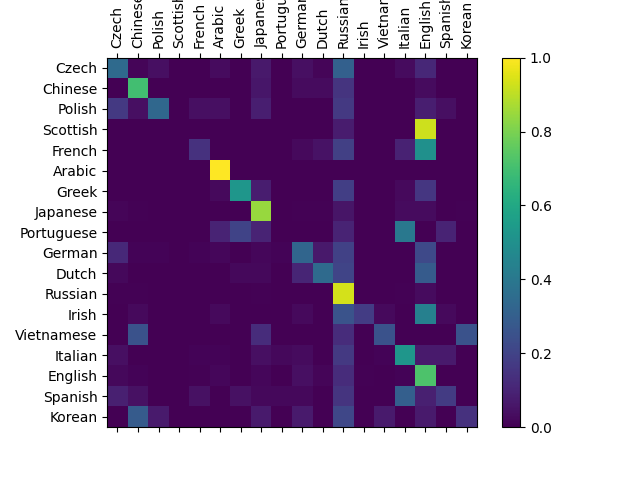

评估结果#

为了查看网络在不同类别上的表现如何,我们将创建一个混淆矩阵,指示每个实际语言(行)的网络猜测的语言(列)。为了计算混淆矩阵,将一批样本通过evaluate()函数传递给网络,这与train()函数相同,只是没有反向传播。

def evaluate(rnn, testing_data, classes):

confusion = torch.zeros(len(classes), len(classes))

rnn.eval() #set to eval mode

with torch.no_grad(): # do not record the gradients during eval phase

for i in range(len(testing_data)):

(label_tensor, text_tensor, label, text) = testing_data[i]

output = rnn(text_tensor)

guess, guess_i = label_from_output(output, classes)

label_i = classes.index(label)

confusion[label_i][guess_i] += 1

# Normalize by dividing every row by its sum

for i in range(len(classes)):

denom = confusion[i].sum()

if denom > 0:

confusion[i] = confusion[i] / denom

# Set up plot

fig = plt.figure()

ax = fig.add_subplot(111)

cax = ax.matshow(confusion.cpu().numpy()) #numpy uses cpu here so we need to use a cpu version

fig.colorbar(cax)

# Set up axes

ax.set_xticks(np.arange(len(classes)), labels=classes, rotation=90)

ax.set_yticks(np.arange(len(classes)), labels=classes)

# Force label at every tick

ax.xaxis.set_major_locator(ticker.MultipleLocator(1))

ax.yaxis.set_major_locator(ticker.MultipleLocator(1))

# sphinx_gallery_thumbnail_number = 2

plt.show()

evaluate(rnn, test_set, classes=alldata.labels_uniq)

您可以从主对角线以外的亮点中看出它猜错的语言,例如将韩语猜成中文,将意大利语猜成西班牙语。它似乎对希腊语表现得非常好,对英语表现得很差(可能是因为与其他语言有重叠)。

练习#

使用更大和/或形状更好的网络可以获得更好的结果。

调整超参数以提高性能,例如更改训练轮数、批次大小和学习率。

尝试使用

nn.LSTM和nn.GRU层。修改层的大小,例如增加或减少隐藏节点的数量,或添加额外的线性层。

将多个RNN组合成一个更高级的网络。

尝试使用不同的行-标签数据集,例如:

任何单词 -> 语言

名字 -> 性别

字符名 -> 作者

页面标题 -> 博客或子版块

脚本总运行时间: (5 分钟 51.591 秒)