ReduceLROnPlateau#

- class torch.optim.lr_scheduler.ReduceLROnPlateau(optimizer, mode='min', factor=0.1, patience=10, threshold=0.0001, threshold_mode='rel', cooldown=0, min_lr=0, eps=1e-08)[源码]#

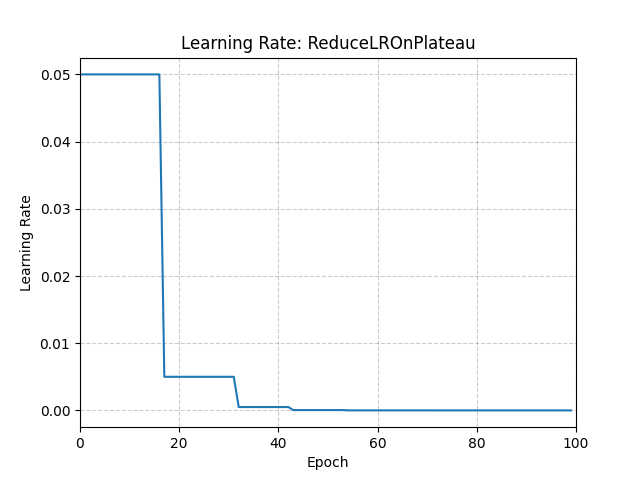

当指标停止改进时,降低学习率。

模型通常受益于在学习停滞后将学习率降低 2-10 倍。此调度器读取一个指标量,如果在“patience”个 epoch 内没有看到改进,则学习率会降低。

- 参数

optimizer (Optimizer) – 包装的优化器。

mode (str) – min 或 max 之一。在 min 模式下,当监控的量停止减少时,学习率会降低;在 max 模式下,当监控的量停止增加时,学习率会降低。默认为 ‘min’。

factor (float) – 学习率将降低的因子。 new_lr = lr * factor。默认为 0.1。

patience (int) – 在学习率降低之前,允许无改进的 epoch 数量。例如,考虑无耐心 (patience = 0) 的情况。在第一个 epoch 中,建立一个基线,并且由于没有先前的基线,它始终被认为是好的。在第二个 epoch 中,如果性能比基线差,则被认为是不可容忍的 epoch。由于不可容忍 epoch 的计数 (1) 大于耐心级别 (0),因此在 epoch 结束时学习率会降低。从第三个 epoch 开始,如果性能比基线差,学习率将继续在每个 epoch 结束时降低。如果性能提高或保持不变,则不调整学习率。默认为 10。

threshold (float) – 用于测量新最优值的阈值,以便只关注显著的变化。默认为 1e-4。

threshold_mode (str) – rel 或 abs 之一。在 rel 模式下,dynamic_threshold = best * ( 1 + threshold )(在 ‘max’ 模式下)或 best * ( 1 - threshold )(在 min 模式下)。在 abs 模式下,dynamic_threshold = best + threshold(在 max 模式下)或 best - threshold(在 min 模式下)。默认为 ‘rel’。

cooldown (int) – 学习率降低后恢复正常操作前等待的 epoch 数量。默认为 0。

eps (float) – 应用于学习率的最小衰减。如果新旧学习率之间的差值小于 eps,则忽略更新。默认为 1e-8。

示例

>>> optimizer = torch.optim.SGD(model.parameters(), lr=0.1, momentum=0.9) >>> scheduler = ReduceLROnPlateau(optimizer, "min") >>> for epoch in range(10): >>> train(...) >>> val_loss = validate(...) >>> # Note that step should be called after validate() >>> scheduler.step(val_loss)